您的位置:主页 > 公司动态 > 公司新闻 > 公司新闻

英伟达GPU,警钟敲响-期货开户

在传出法国将对英伟达提议反垄断观察后不久,又有新的欠好新闻传出。

据彭博社引述欧盟竞争事务认真人玛格丽特·维斯塔格 (Margrethe Vestager) 的忠告称,英伟达公司的 AI 芯片供应存在“伟大瓶颈”,但示意羁系机构仍在思量若何解决这个问题。

“我们一直在向他们询问问题,但这还只是开端问题,”她在新加坡之行中告诉彭博社。到现在为止,这“还不具备羁系行动的条件”。

自从英伟杀青为人工智能支出热潮的*受益者以来,羁系机构就一直关注着它。它的图形处置单元(简称 GPU)因其能够处置开发 AI 模子所需的大量信息的能力而受到数据中央运营商的青睐。

芯片已成为科技界最热门的商品之一,云盘算提供商相互竞争以获取这些芯片。据估量,Nvidia 的 H100 处置器需求兴旺,已辅助他们获得 80% 以上的市场份额,*于竞争对手英特尔公司和超微半导体公司。

只管供应主要,但 Vestager 示意,人工智能芯片供应的二级市场可能有助于引发创新和公正竞争。

但她示意,占主导职位的公司未来可能会晤临某些行为限制。

“若是你在市场上拥有这种主导职位,那么有些事情你不能做,而小公司可以做,”她说。“但除此之外,只要你做你的生意并尊重这一点,你就很好。”

6000亿美元的“浩劫题”

只管高科技巨头在人工智能基础设施方面投入了大量资金,但人工智能带来的收入增进尚未实现,这解释生态系统的最终用户价值存在伟大差距。事实上, 红杉资源剖析师戴维·卡恩( David Cahn)以为,人工智能公司每年必须赚取约 6000 亿美元才气支付其人工智能基础设施(例如数据中央)的用度。

去年,Nvidia 的数据中央硬件收入到达 475 亿美元(其中大部门硬件是用于 AI 和 HPC 应用的盘算 GPU)。AWS、Google、Meta、Microsoft等公司在 2023 年为 OpenAI 的 ChatGPT 等应用在其 AI 基础设施上投入了巨额资金。然而,他们能赚回这笔投资吗?David Cahn 以为,这可能意味着我们正在眼见金融泡沫的增进。

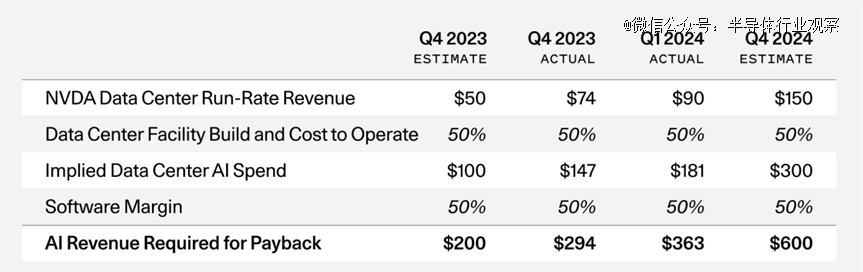

根据David Cahn的算法,6000亿美元这个数字,可以通过一些简朴的数学运算来得出。

你所要做的就是将 Nvidia 的运行率收入展望乘以 2 倍,以反映 AI 数据中央的总成本(GPU 占总拥有成本的一半,另一半包罗能源、修建物、备用发电机等)。然后你再乘以 2 倍,以反映 GPU 最终用户的 50% 毛利率(例如,从 Azure 或 AWS 或 GCP 购置 AI 盘算的初创公司或企业,他们也需要赚钱)。

我们看看,自 2023 年 9 月(在那时,他以为人工智能是2000亿美元难题)以来发生了什么转变?

一、供应欠缺已经消退:2023 年终是 GPU 供应欠缺的岑岭期。初创公司正在给风险投资公司打电话,给任何愿意与他们攀谈的人打电话,追求辅助以获得 GPU。现在,这种担忧险些完全消除了。对于我攀谈过的大多数人来说,现在以合理的交货时间获得 GPU 相对容易。

二、GPU 库存不停增进:Nvidia 在第四序度讲述称,其数据中央收入的一半左右来自信型云提供商。仅微软一家就可能占Nvidia 第四序度收入的约 22%。超大规模资源支出正在到达历史水平。这些投资是大型科技公司 2024 年*季度收益的主要主题,首席执行官们有用地告诉市场:“无论你喜不喜欢,我们都市投资 GPU。”囤积硬件并不是一个新征象,一旦库存足够大以至于需求下降,就会成为重置的催化剂。

三、OpenAI 仍然占有着 AI 收入的*份额:The Information 最近报道称,OpenAI 的收入现在为34 亿美元,高于 2023 年底的 16 亿美元。虽然我们已经看到少数初创公司的收入规模到达不到 1 亿美元,但 OpenAI 与其他公司之间的差距仍然很大。除了 ChatGPT,消费者今无邪正使用了若干 AI 产物?想想你每月花 15.49 美元从 Netflix 或每月花 11.99 美元从 Spotify 获得若干价值。从久远来看,AI 公司需要为消费者提供伟大的价值,才气继续掏钱。

四、1250 亿美元的缺口现在酿成了 5000 亿美元的缺口:在最后的剖析中,我慷慨地假设谷歌、微软、苹果和 Meta 每年都能重新的 AI 相关收入中发生 100 亿美元。我还假设甲骨文、字节跳动、阿里巴巴、腾讯、X 和特斯拉每年都有 50 亿美元的新 AI 收入。纵然这仍然是准确的,而且我们在名单上再添加几家公司,1250 亿美元的缺口现在也会酿成 5000 亿美元的缺口。

这还没完——B100 即将问世: 今年早些时刻,Nvidia 宣布推出 B100 芯片,其性能提升了 2.5 倍,而成本仅增添了 25%。我预计这将导致 NVDA 芯片需求的最终激增。与 H100 相比,B100 的成本与性能相比有了显著的改善,而且由于每小我私人都想在今年晚些时刻买到 B100,因此很可能再次泛起供应欠缺。

在之条件出关于GPU的问题时,David Cahn收到的最主要反驳之一是“GPU 资源支出就像修建铁路”,最终火车会开过来,目的地也会到来——新的农业出口、游乐园、购物中央等。

David Cahn示意,实在他也赞成这一点,但他以为这个论调忽略了几点:

中药餐饮卷土重来,能火多久?

一、缺乏订价权:在物理基础设施建设的情形下,您正在建设的基础设施具有一些内在价值。若是您拥有旧金山和洛杉矶之间的轨道,那么您可能拥有某种垄断订价权,由于 A 地和 B 地之间只能铺设这么多轨道。在 GPU 数据中央的情形下,订价权要小得多。GPU 盘算正日益成为一种按小时计量的商品。与成为寡头垄断的 CPU 云差异,构建专用 AI 云的新进入者继续涌入市场。在没有垄断或寡头垄断的情形下,高牢靠成本 低边际成本的企业险些总是会看到价钱竞争到边际成本(例如航空公司)。

二、投资虚耗:纵然是铁路行业,以及许多新手艺行业,投契性投资怒潮也经常导致高额的资源虚耗。《The Engines that Moves Markets 》是一本关于手艺投资的*教科书,其主要看法(确实,重点关注铁路行业)是,许多人在投契性手艺浪潮中损失惨重。挑选赢家很难,但挑选输家(就铁路行业而言,运河)要容易得多。

三、折旧:从手艺生长史中我们得知,半导体趋于越来越好。Nvidia 将继续生产更好的下一代芯片,如 B100。这将导致上一代芯片的折旧速率加速。由于市场低估了 B100 和下一代芯片的改善速率,因此它高估了今天购置的 H100 在 3-4 年后的价值。同样,物理基础设施不存在这种相似性,它不遵照任何“摩尔定律”类型的曲线,因此成本与性能的关系不停改善。

四、赢家与输家:我以为我们需要仔细研究赢家和输家——在基础设施建设过剩的时期,总会有赢家。人工智能很可能是下一波变化性手艺浪潮,GPU 盘算价钱的下降现实上也有利于耐久创新,也有利于初创企业。若是David Cahn的展望成真,它将主要对投资者造成危险。首创人和公司建设者将继续在人工智能领域生长——他们将更有可能取得乐成,由于他们将受益于较低的成本和在这一试验时代积累的履历。

五、人工智能将缔造伟大的经济价值。专注于为最终用户提供价值的公司确立者将获得丰盛的回报。我们正在履历一场可能界说一代人的手艺浪潮。像 Nvidia 这样的公司在推动这一转变方面施展了主要作用,值得赞美,而且很可能在未来很长一段时间内在生态系统中施展要害作用。

不外David Cahn也重申,投契怒潮是手艺的一部门,以是没什么好畏惧的。那些在这一刻保持头脑苏醒的人有时机确立极其主要的公司。但我们必须确保不要信托现在已经从硅谷伸张到天下甚至全天下的妄想。这种妄想以为我们都市快速致富,由于 AGI 明天就会到来,我们都需要储存*有价值的资源,那就是 GPU。

“事实上,前面的蹊径将是漫长的。它会有起有落。但险些可以一定,它是值得的。”David Cahn强调。

潜在的挑战者

虽然这是一个谈了许多次,但似乎也有了却果的论调。如Futurum Group 首席执行官丹尼尔·纽曼所说,“现在,天下上没有英伟达的天敌。”

缘故原由如下:Nvidia 的图形处置单元 (GPU) 最初于 1999 年为 PC 视频游戏中的超快 3D 图形而确立,厥后被证实异常适合训练大规模天生式 AI 模子,来自 OpenAI、Google、Meta、Anthropic 和 Cohere 等公司推动的模子的规模越来越大,进而需要使用大量 AI 芯片来做训练。多年来,Nvidia 的 GPU 一直被以为是最壮大的,也是最抢手的。

这些成本固然不菲:训练*天生式 AI 模子需要数万个*的 GPU,每个 GPU 的价钱为 3 万至 4 万美元。例如,埃隆·马斯克 (Elon Musk)最近示意,他的公司 xAI 的 Grok 3 模子需要在 10 万个 Nvidia * GPU 上举行训练才气成为“特其余器械”,这将为 Nvidia 带来跨越 30 亿美元的芯片收入。

然而,Nvidia 的乐成不仅仅是芯片的产物,另有让芯片变得易于使用的软件。Nvidia 的软件生态系统已经成为大量专注于 AI 的开发职员的*,他们险些没有动力去转换。在上周的年度股东大会上,Nvidia 首席执行官黄仁勋称该公司的软件平台 CUDA(盘算统一装备架构)是一个“良性循环”。随着用户的增多,Nvidia 有能力投入更多资金升级该生态系统,从而吸引更多用户。

相比之下,Nvidia 的半导体竞争对手AMD控制着全球 GPU 市场约 12% 的份额,该公司确实拥有具有竞争力的 GPU,而且正在改善其软件,纽曼说。然则,虽然它可以为不想被 Nvidia 约束的公司提供另一种选择,但它没有现有的开发者用户群,这些开发者以为 CUDA 易于使用。

此外,虽然亚马逊的 AWS、微软Azure 和谷歌云等大型云服务提供商都生产自己的专有芯片,但他们并不设计取代 Nvidia。相反,他们希望有多种 AI 芯片可供选择,以优化自己的数据中央基础设施,降低价钱,并向最普遍的潜在客户群销售他们的云服务。

J. Gold Associates 剖析师杰克·戈尔德 (Jack Gold) 注释说:“Nvidia 拥有早期生长势头,当你确立一个快速增进的市场时,其他人很难遇上。”他示意 Nvidia 在确立其他人所没有的怪异生态系统方面做得很好。

Wedbush 股票研究高级副总裁 Matt Bryson 弥补说,要取代 Nvidia 用于训练大规模 AI 模子的芯片将稀奇难题,他注释说,现在盘算能力的大部门支出都流向了这一领域。“我以为这种动态在未来一段时间内不会发生转变,”他说。

然而,越来越多的人工智能芯片初创公司,包罗 Cerebras、SambaNova、Groq 以及最新的 Etched和 Axelera ,都看到了从英伟达人工智能芯片营业中分一杯羹的时机。他们专注于知足人工智能公司的特殊需求,尤其是所谓的“推理”,即通过已经训练过的人工智能模子运行数据,让模子输出信息(例如,ChatGPT 的每个谜底都需要推理)。

例如,就在上周,Etched筹集了1.2 亿美元,用于开发一种专门用于运行 transformer 模子的专用芯片Sohu,Transformer 模子是 OpenAI 的 ChatGPT、谷歌的 Gemini 和 Anthropic 的 Claude 使用的一种 AI 模子架构。据先容,该芯片将由台积电接纳其 4nm 工艺生产,该公司示意还已从“*供应商”那里获得高带宽内存和服务器供应,但没有透露这些公司的名字。Etched 还声称,Sohu 的速率比 Nvidia 即将推出的 Blackwell GPU“快一个数目级,而且更廉价”,八芯片 Sohu 服务器每秒可处置跨越 500,000 个 Llama 70B token。该公司通过推断已宣布的 Nvidia H100 服务器 MLperf 基准测试数据做出了这一判断,该基准测试显示,八 GPU 服务器每秒可处置 23,000 个 Llama 70B token。Etched 首席执行官 Uberti在接受采访时示意,一台Sohu服务器将取代 160 块 H100 GPU。

荷兰初创公司 Axelera AI 正在开发用于人工智能应用的芯片,该公司上周宣称也已获得6800万美元美元融资,该公司正在筹集资金以支持其雄心壮志的增进设计。这家总部位于埃因霍温的公司旨在成为欧洲版的 Nvidia,提供据称比竞争对手节能 10 倍、价钱廉价 5 倍的 AI 芯片。Axelera 创新的焦点是 Thetis Core 芯片,它在一个周期内可以执行惊人的 260,000 次盘算,而通俗盘算机只能执行 16 次或 32 次盘算。这种能力使其异常适合 AI 神经网络盘算,主要是矢量矩阵乘法。他们的芯片提供了高性能和可用性,而成本仅为现有市场解决方案的一小部门。这可以使 AI 普及,让更普遍的应用程序和用户能够使用它。

与此同时,据报道,专注于以闪电般的速率运行模子的 Groq 正在以25 亿美元的估值筹集新资金,而 Cerebras据称在宣布其最新芯片仅几个月后就隐秘提交了首次公然募股申请,该公司声称该芯片可以训练比 GPT-4 或 Gemini 大 10 倍的 AI 模子。

所有这些初创公司一最先都可能专注于一个小市场,好比为某些义务提供更高效、更快或更廉价的芯片。他们也可能更专注于特定行业的专用芯片或小我私人电脑和智能手机等人工智能装备。“*的战略是开拓一个小众市场,而不是试图征服天下,而这正是他们大多数人正在实验做的,”Tirias Research 首席剖析师 Jim McGregor 说。

因此,也许更切题的问题是:这些初创公司与云提供商以及 AMD 和英特尔等半导体巨头一起能够占领若干市场份额?这另有待考察,尤其是由于运行 AI 模子或推理的芯片市场仍然很新。

参考链接